当人们谈论互联网大数据时,常常会联想到海量、爆炸、无穷无尽等词汇。这些抽象的形容词往往难以真正描绘其庞大尺度。互联网的大数据规模,实际上已经远远超出了普通人的想象力边界,而支撑其运转的互联网数据服务,则构成了现代社会不可或缺的数字基石。

1. 数据洪流:每秒都在刷新认知的体量

互联网大数据究竟有多大?不妨先看几个直观的数据:

据统计,全球互联网用户每天产生约2.5万亿字节的数据。这相当于每天产出约250万部高清电影,如果将这些电影连续播放,需要超过5万年才能看完。每分钟,YouTube用户上传超过500小时的视频,Netflix用户观看超过2.5万小时的节目;每秒钟,谷歌处理超过10万次搜索查询。这些实时生成的数据流,仅仅是冰山一角。

从存储角度看,全球数据总量正以指数级速度增长。根据国际数据公司(IDC)的预测,到2025年,全球数据圈(指每年创建、捕获、复制和消费的数据总量)预计将达到175 ZB(泽字节)。1 ZB相当于1万亿GB,而175 ZB的数据量,如果存储在常见的DVD光盘上,这些光盘叠起来的高度足以从地球往返月球近23次。

2. 数据来源:无处不在的生成节点

互联网大数据的庞大,源于其来源的广泛性和多样性:

- 社交网络与通讯:微信、Facebook、Twitter等平台每天产生数百亿条消息、图片和视频。

- 物联网设备:智能家居、工业传感器、车载系统等数十亿设备持续采集环境、行为和状态数据。

- 商业与交易:电子商务、在线支付、物流追踪每笔交易都生成多维度数据。

- 科学研究:天文观测、基因测序、粒子对撞实验等产生PB级乃至EB级数据集。

- 多媒体内容:短视频、直播、在线游戏等富媒体应用是数据增长的主要驱动力之一。

这些数据不仅体量巨大,而且往往具有高速(Velocity)、多样(Variety)、实时(Real-time)等特征,对处理技术提出了极致挑战。

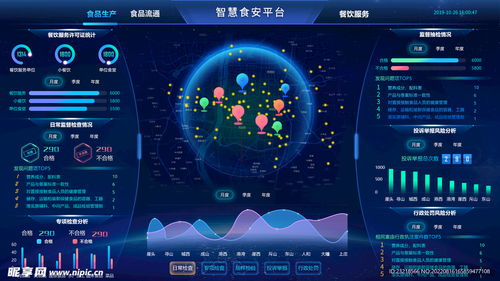

3. 互联网数据服务:驾驭数据洪流的“方舟”

面对如此浩瀚的数据海洋,互联网数据服务应运而生,成为组织、处理、分析并赋能应用的关键基础设施。主要包括:

- 数据存储与管理:

分布式文件系统(如HDFS)、NoSQL数据库(如MongoDB)、云存储服务(如AWS S3)等,提供了可扩展、高可用的数据存贮方案。对象存储服务已能支持EB级数据池,满足海量非结构化数据的存储需求。

- 数据处理与计算:

以Hadoop、Spark为代表的分布式计算框架,允许在成千上万台服务器上并行处理PB级数据。流处理引擎(如Flink、Kafka Streams)则能对高速数据流进行实时分析与响应,延迟可低至毫秒级。

- 数据分析与智能:

数据仓库、OLAP系统及AI平台,使企业能从数据中挖掘趋势、预测行为。例如,推荐系统每天处理万亿级特征,优化用户体验;城市大脑实时分析数十万路视频流,提升治理效率。

- 数据服务与API经济:

许多公司将数据能力封装为服务,通过API开放。例如,地理位置服务、金融风控模型、图像识别接口等,让开发者无需从头构建数据基础设施,即可集成强大功能。

4. 未来展望:从“大”到“智能”的演进

互联网大数据仍在加速膨胀,而数据服务的发展焦点已逐渐从单纯存储处理,转向数据价值深挖与合规高效利用:

- 边缘计算与云边协同:将计算推向数据源头,减少延迟与带宽压力,满足物联网、自动驾驶等场景需求。

- 隐私计算与数据安全:在数据不出域的前提下,通过联邦学习、多方安全计算等技术实现联合建模,平衡价值挖掘与隐私保护。

- AI驱动的数据自治:利用机器学习自动完成数据分类、质量检测、异常监测,降低管理成本。

- 可持续发展:优化数据中心能效,采用绿色能源,应对数据增长带来的巨大能耗挑战。

###

互联网的大数据,已不仅是一个技术概念,更是如同新时代的“自然资源”,其规模之大、增长之快,持续挑战着人类的技术极限与认知边界。而互联网数据服务,则是我们驾驭这片数字海洋的航船与罗盘。它让无序的数据洪流转化为有序的信息,让潜在的洞察显现为现实的价值。在随着量子计算、神经形态计算等新技术的融合,我们或许能以今天难以想象的方式,探索并利用那些“完全超出想象力”的数据宇宙。理解其宏大,善用其服务,正是数字时代赋予我们的关键课题。